Context Engineering etabliert sich als das neue Paradigma in der KI-Entwicklung. Führende Experten sind sich einig: Die Ära des „perfekten Prompts“ ist vorbei. Stattdessen geht es nun darum, dynamische Systeme zu entwickeln, die zur richtigen Zeit die richtigen Informationen und Werkzeuge bereitstellen.

Executive Summary

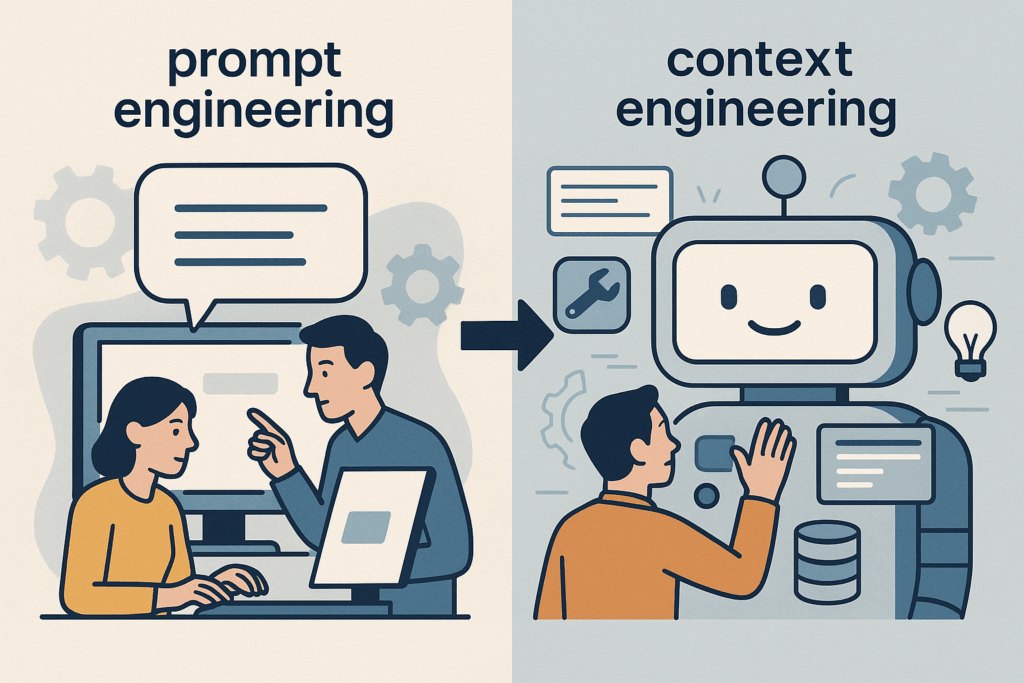

Die KI-Landschaft erlebt einen fundamentalen Wandel: Context Engineering löst Prompt Engineering als dominierende Disziplin ab. Während Prompt Engineering auf statische Textanweisungen setzte, orchestriert Context Engineering komplexe, dynamische Informationssysteme. Dieser Paradigmenwechsel ermöglicht es, von oberflächlichen KI-Demos zu wirklich intelligenten, kontextbewussten Anwendungen überzugehen. Unternehmen, die diesen Wandel früh erkennen und umsetzen, werden entscheidende Wettbewerbsvorteile erlangen.

Die Visionäre des Wandels

Andrew Karpathy, ehemaliges OpenAI-Gründungsmitglied und Tesla AI-Direktor, propagiert den Übergang: „Context Engineering ist die delikate Kunst und Wissenschaft, das Kontextfenster mit genau den richtigen Informationen für den nächsten Schritt zu füllen“. Diese Definition macht deutlich, dass wir es nicht mehr mit simplen Textanweisungen zu tun haben, sondern mit der systematischen Orchestrierung komplexer Informationsarchitekturen.

Shopify CEO Tobi Lütke ergänzt diese Sichtweise prägnant: Context Engineering ist „die Kunst, allen Kontext bereitzustellen, damit eine Aufgabe vom LLM plausibel lösbar wird“.

Context Engineering: System statt String

Phil Schmids wegweisende Analyse zeigt den fundamentalen Unterschied auf: Context Engineering ist kein statisches Prompt-Template, sondern die Ausgabe eines dynamischen Systems, das vor dem Haupt-LLM-Aufruf läuft. Diese systemische Perspektive transformiert die gesamte Herangehensweise an KI-Anwendungen.

Der Unterschied zwischen einem oberflächlichen Demo und einem intelligenten Agenten liegt ausschließlich in der Kontextqualität. Ein traditioneller Ansatz würde auf eine E-Mail wie „Hey, just checking if you’re around for a quick sync tomorrow“ eine generische Antwort liefern. Ein Context Engineering System dagegen würde dynamisch Kalenderinformationen, E-Mail-Historie, Kontaktdaten und verfügbare Tools einbeziehen.

Die sieben Säulen des Context Engineering

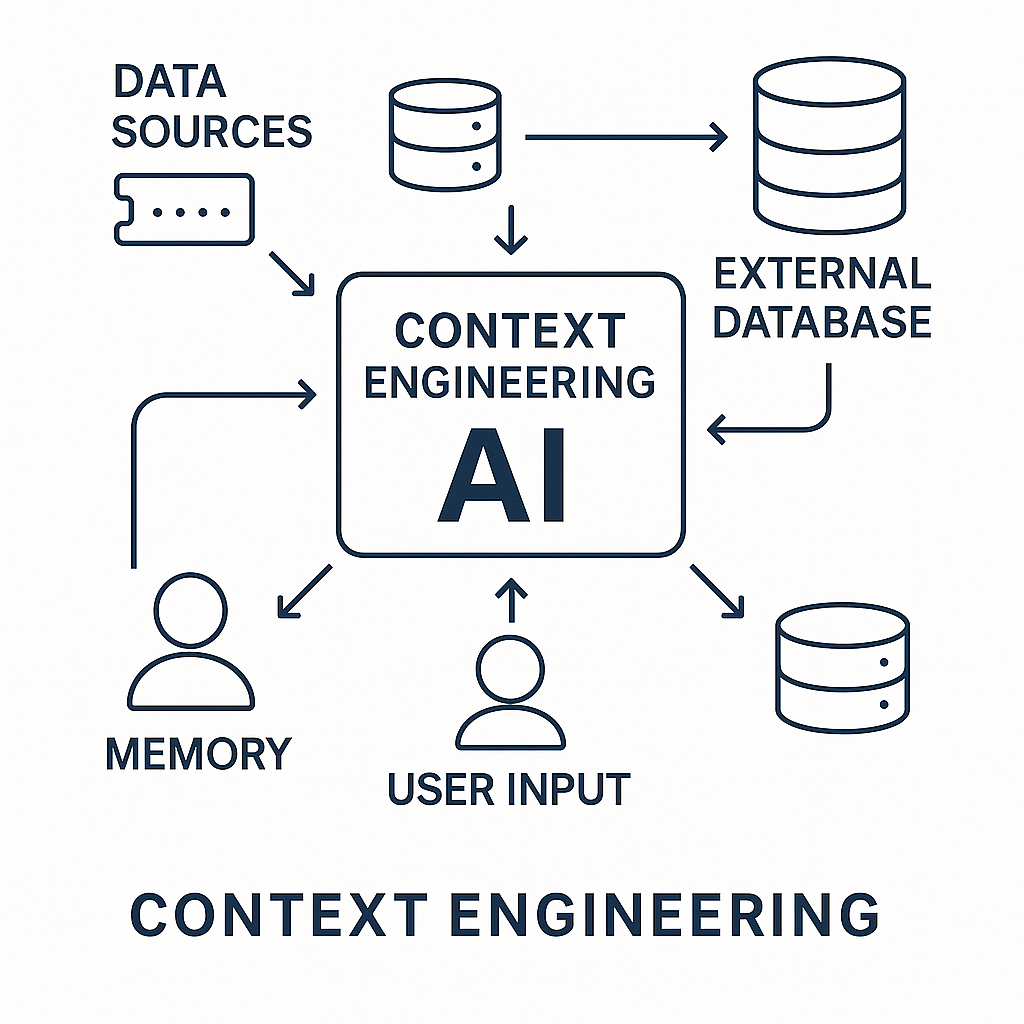

Moderne Context Engineering Systeme basieren auf sieben Kernkomponenten, die dynamisch orchestriert werden müssen:

- Instructions/System Prompt: Grundlegende Verhaltensregeln mit Beispielen

- User Prompt: Die unmittelbare Aufgabe oder Frage des Nutzers

- State/History: Aktuelle Unterhaltung und Modell-Antworten

- Long-Term Memory: Persistente Wissensbasis aus vorherigen Gesprächen

- Retrieved Information (RAG): Aktuelle externe Wissensdatenbanken

- Available Tools: Funktionsdefinitionen für aufrufbare Tools

- Structured Output: Formatdefinitionen für die Modell-Antwort

Dynamische Systemarchitektur des Context Engineering

Die fünf Grundprinzipien

Das LangChain-Team definiert Context Engineering durch fünf fundamentale Prinzipien:

- System, nicht String: Komplexe Agenten beziehen Kontext aus vielen Quellen

- Dynamische Systeme: Kontextteile werden dynamisch hinzugefügt

- Richtige Information: LLMs benötigen die richtigen Informationen

- Richtige Tools: LLMs brauchen passende Werkzeuge für jede Aufgabe

- Format ist entscheidend: Die Art der Kommunikation ist genauso wichtig wie der Inhalt

RAG: Das Herzstück moderner Kontextsysteme

Retrieval-Augmented Generation (RAG) hat sich als Kerntechnologie etabliert. RAG ermöglicht es LLMs, relevante Informationen aus externen Datenquellen abzurufen und in ihre Antworten zu integrieren. Dies reduziert Halluzinationen erheblich und ermöglicht die Arbeit mit aktuellen, domänenspezifischen Informationen.

Die RAG-Pipeline funktioniert in drei Schritten:

- Retrieval: Abfrage einer externen Wissensbasis

- Augmentation: Kombination der abgerufenen Daten mit der ursprünglichen Anfrage

- Generation: LLM-basierte Antwortgenerierung unter Verwendung des erweiterten Kontexts

Memory-Systeme: Die Grundlage intelligenter Agenten

Moderne KI-Agenten implementieren dreischichtige Memory-Architekturen:

Config: Runtime-Daten für spezifische Aufrufe – unveränderlich während der Ausführung

Short-term Memory: Dynamische Daten während der Ausführung – änderbar pro Gespräch

Long-term Memory: Persistente, gespräch-übergreifende Informationen

Diese Speichersysteme ermöglichen es KI-Agenten, episodische, semantische und prozedurale Erinnerungen zu entwickeln.

Das Model Context Protocol: Standardisierung der Zukunft

Anthropics Model Context Protocol (MCP) revolutioniert die Art, wie KI-Systeme mit Datenquellen interagieren. Anstatt für jede Datenquelle individuelle Integrationen zu erstellen, bietet MCP ein universelles Protokoll für eleganten Kontextfluss zwischen KI und Systemen.

MCP löst kritische Probleme:

- Universeller Zugang: Einzelnes Protokoll für alle Datenquellen

- Sichere Verbindungen: Ersetzt Ad-hoc-API-Konnektoren

- Nachhaltigkeit: Wiederverwendbare Konnektoren für verschiedene LLMs

Praktische Anwendungsbereiche

Context Engineering zeigt seine transformative Kraft in spezialisierten Unternehmensanwendungen:

Kundenservice: Chatbots berücksichtigen vorherige Interaktionen, Kundenprofile und Geschäftsdaten für personalisierte Lösungen.

Gesundheitswesen: Medizinische KI-Systeme integrieren Patientengeschichte, aktuelle Symptome und medizinische Datenbanken.

Rechtswesen: KI-Assistenten für Rechtsforschung kombinieren dynamisch Gesetze, Präzedenzfälle und Fallspezifika.

Herausforderungen und Optimierungsstrategien

Context Engineering bringt spezifische technische Herausforderungen mit sich:

Kontextfenster-Management: Die effiziente Nutzung begrenzter Kontextfenster erfordert intelligente Priorisierung. Techniken wie Chunking und kontextuelle Embeddings helfen dabei.

Kosten- und Latenzoptimierung: Optimierungsstrategien umfassen Caching häufig verwendeter Kontexte und hierarchische Kontextverarbeitung.

Qualität vs. Quantität: Zu wenig Kontext führt zu ungenauen Antworten, zu viel irrelevanter Kontext kann die Leistung beeinträchtigen.

Der neue Beruf: Context Engineer

Die Industrie entwickelt bereits neue Berufsbilder rund um Context Engineering. Diese Rolle erfordert sowohl technische Kernkompetenzen (Vector Database Management, Embedding-Technologien, RAG-Systemarchitektur) als auch Business-Integration (Geschäftsprozessanalyse, Governance-Strukturen, Performance-Optimierung).

Messbare Geschäftsvorteile

Unternehmen, die Context Engineering systematisch implementieren, berichten von erheblichen Verbesserungen in Genauigkeit, Effizienz und Benutzerzufriedenheit. Die Implementierung führt zu reduzierten Fehlerquoten, Kostensenkungen und schnelleren Entwicklungszeiten.

Praktische Implementierung: Der Weg nach vorn

Die Implementierung sollte stufenweise erfolgen:

Phase 1: Beginn mit dynamischer Kontexterfassung durch klärende Fragen

Phase 2: Integration von RAG für domänenspezifisches Wissen

Phase 3: Entwicklung von Memory-Systemen für persistente Kontexte

Phase 4: Aufbau multimodaler Kontextverarbeitung

Ein einfacher, aber wirkungsvoller Einstieg ist die Technik: „Stellen Sie mir klärende Fragen, bevor Sie beginnen“. Diese Methode aktiviert dynamische Kontexterfassung statt statischer Prompts und verbessert die Ergebnisqualität erheblich.

Die Zukunft: Multimodale und autonome Systeme

Die nächste Evolutionsstufe führt zu multimodalen Systemen, die Text, Bilder, Audio und andere Datentypen kohärent integrieren. Zukünftige Entwicklungen zielen auf autonome KI-Agenten ab, die komplexe Aufgaben durch sophisticated Context Management selbstständig lösen können.

Fazit: Der Paradigmenwechsel ist unaufhaltsam

Context Engineering ist nicht nur eine Technik – es ist die Grundlage für die nächste Generation intelligenter, kontextbewusster KI-Systeme. Die Ära der „perfekten Prompts“ ist definitiv vorbei. Die Zukunft gehört intelligenten Systemen, die dynamisch den richtigen Kontext zur richtigen Zeit bereitstellen.

Organisationen, die diese Prinzipien früh adaptieren, werden KI-Systeme entwickeln, die ihr Geschäft wirklich verstehen. Diese Systeme werden Informationsbedürfnisse antizipieren, institutionelles Wissen bewahren und kontinuierlich aus Nutzungsmustern lernen.

Beginnen Sie heute damit, Ihre KI-Interaktionen zu überdenken. Fragen Sie sich: Nutzen Sie noch statische Prompts oder bereits dynamische Kontextsysteme? Die Antwort entscheidet über Ihren Erfolg in der KI-Zukunft.