Stellen Sie sich vor: Es ist Montagmorgen, und Ihr digitaler Assistent „Ava“ hat bereits im Morgengrauen eigenständig die Server-Logs der Nacht analysiert, Kundendatenbanken aktualisiert und sogar mit dem Einkaufs-Agenten eines Lieferanten verhandelt – alles, bevor Sie Ihren ersten Kaffee getrunken haben. Während Sie noch die Augen reiben, präsentiert Ava Ihnen eine übersichtliche Zusammenfassung für das Team-Meeting. Was hier wie Science-Fiction klingt, könnte schon bald Arbeitsalltag werden. KI-Agenten entwickeln sich rasant weiter und versprechen, unsere Art zu arbeiten grundlegend zu verändern. In diesem Beitrag beleuchten wir drei Schlüsselaspekte dieser Zukunft: die Standardisierung der Konnektivität von KI-Agenten über Model Context Protocol (MCP), neue „Maschinensprachen“ für KI-Agenten jenseits von Englisch, und wegweisende Zukunftstrends wie Automatisierung, Dezentralisierung und innovative Schnittstellen. Die Mischung aus Storytelling und Analyse soll Tech-Managern praxisnahe Einblicke bieten – damit Sie vorbereitet sind, wenn Assistent Ava und ihre digitalen Kollegen Realität werden.

Standardisierte Konnektivität: KI-Agenten sprechen „USB-C“

Eines der größten Hindernisse für heutige KI-Agenten ist die Anbindung an verschiedene Datenquellen, Tools und Systeme. Aktuell erfordert jede Integration meist eine Sonderlösung – ein spezifisches API hier, ein maßgeschneidertes Skript dort. Diese Fragmentierung führt dazu, dass ein KI-Agent zwar beeindruckende Antworten generieren kann, ihm aber oft der einfache Zugriff auf aktuelle und unternehmensspezifische Informationen fehlt. Genau hier setzt das Model Context Protocol (MCP) an, ein offener Standard, der von Anthropic eingeführt wurde (MCP – Model Context Protocol: The New Standard for AI Data Connectivity).

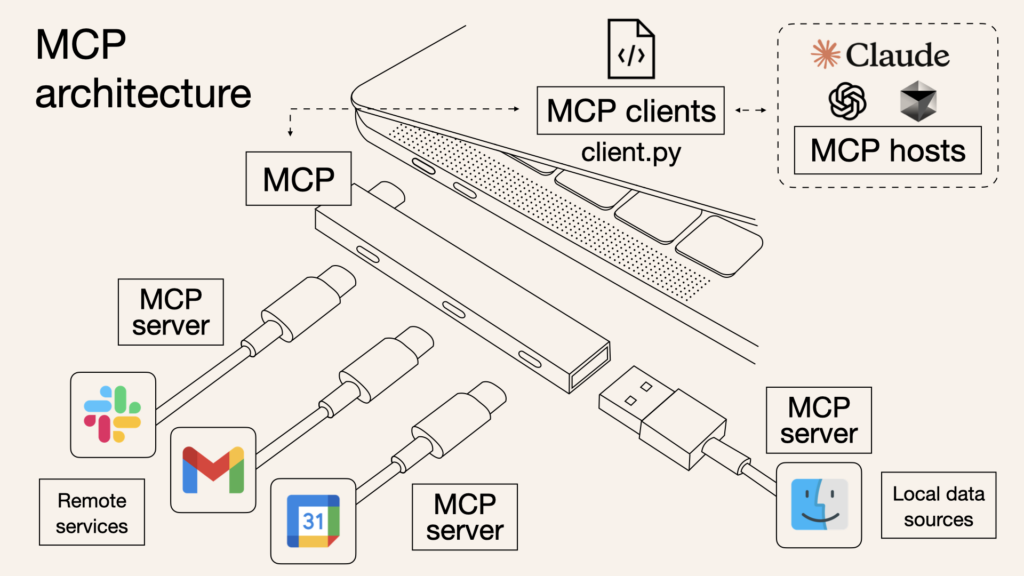

MCP fungiert als universelle Schnittstelle – man könnte sagen als „USB-C“ für KI-Konnektivität. Es ermöglicht Language Models dynamisch auf externe Tools, Dateien und APIs zuzugreifen, ohne für jedes System eine eigene Anbindung entwickeln zu müssen. Statt proprietärer Plugin-Formate oder unzähliger Sonderlocken bietet MCP einen einheitlichen Weg, um Kontext und Daten an KI-Agenten zu übergeben. Das hat gleich mehrere Vorteile: Entwickler müssen nicht mehr für jedes neue Tool das Rad neu erfinden, und Unternehmen können ihre bestehenden Datenquellen – ob Datenbanken, Cloud-Dienste oder interne Dokumentationen – viel einfacher andocken (Anthropics Model Context Protocol (MCP): Ein Schritt in Richtung effizienterer KI-Integration – ai-rockstars.de). Im Grunde trennt MCP die Verantwortung: Auf der einen Seite ein MCP-Server, der strukturierte Daten und Funktionen bereitstellt (ähnlich einer Datenbank oder einem Dateisystem für KI), und auf der anderen Seite ein MCP-Client im KI-Agenten, der diese Daten bei Bedarf abruf.

Ein solcher Standard bringt Skaleneffekte mit sich. Anthropic selbst vergleicht MCP mit dem USB-C-Standard, der ja auch dafür sorgte, dass nicht mehr für jedes Gerät ein anderes Ladekabel nötig ist. Genauso soll MCP als universeller Port dienen, über den beliebige KI-Anwendungen mit Services sprechen können. Erste Umsetzungen zeigen, dass damit Werkzeuge und Funktionen „plug-and-play“ für verschiedene Agenten verfügbar werden – unabhängig davon, ob es sich um einen Chatbot im Kundendienst, ein AI-Plugin in einer IDE oder einen persönlichen Assistenten handelt. Die deutsche Tech-Community beobachtet diese Entwicklung genau: MCP bietet eine einheitliche Schnittstelle, standardisiert Tools und parameterisierte Prompts, und minimiert so den Bedarf an maßgeschneidertem Code je Integration. Langfristig könnte dies Integrationszeiten drastisch verkürzen und KI-Projekte beschleunigen. Florian Schröder von AI-Rockstars.de notiert, dass MCP zu effizienteren Prozessen und einer besseren Skalierbarkeit von KI-Ökosystemen führen kann (Anthropics Model Context Protocol (MCP): Ein Schritt in Richtung effizienterer KI-Integration – ai-rockstars.de).

Für Tech-Manager bedeutet das: Interoperabilität wird zum Schlüssel. Wer frühzeitig auf offene Standards wie MCP setzt, stellt sicher, dass seine KI-Agenten schneller auf neue Datenquellen zugreifen können – ohne für jede App von vorn anfangen zu müssen. Zudem reduziert Standardisierung Abhängigkeiten von einzelnen Anbietern. Ähnlich wie offene Protokolle im Internet für Kompatibilität und Innovation sorgten, könnte MCP & Co. die Grundlage für ein vielseitiges KI-Ökosystem bilden, in dem Tools, die heute noch siloartig getrennt sind, morgen nahtlos durch KI-Agenten orchestriert werden.

Maschinen-Dialekte: Wenn KI-Agenten ihre eigene Sprache sprechen

Bislang „unterhalten“ sich KI-Agenten – sofern sie überhaupt miteinander interagieren – vor allem in menschlicher Sprache. Typischerweise würde ein Agent einem anderen z.B. eine Aufgabe in Englisch übermitteln, weil diese Modelle darauf trainiert sind, menschliche Eingaben zu verstehen. Doch für Machine-to-Machine-Kommunikation ist das eigentlich ein Umweg. Englisch mag für uns Menschen effizient sein, für KI-Systeme ist es Ballast. Die Nuancen natürlicher Sprache, die für uns so bedeutungsvoll sind, erzeugen für Maschinen vor allem Overhead: Grammatik, Höflichkeitsfloskeln, Kontext – all das brauchen zwei KIs untereinander nicht, um Informationen auszutauschen (What is Gibberlink: The secret language between AI agents | The Jotform Blog).

Forschende von Microsoft und der University of Chicago haben daher etwas Bahnbrechendes ausprobiert: Sie entwickelten eine eigene Sprache nur für KI-Agenten namens DroidSpeak (Microsoft collaboration develops DroidSpeak for better communication between LLMs). Die Idee dahinter ist bestechend einfach – und doch futuristisch: DroidSpeak basiert auf der „mathematischen Sprache“ der KI-Modelle selbst. Anstatt Sätze in Englisch zu formulieren, tauschen die Agenten in DroidSpeak direkt abstrakte, strukturierte Repräsentationen aus, die dem entsprechen, wie die Modelle intern „denken“. Die Anspielung an „Droid“ aus Star Wars kommt nicht von ungefähr: Wie die Droiden im Film piepsen die KI-Modelle in einer Art maschinellem Dialekt. Und tatsächlich zeigt sich ein enormes Effizienzpotenzial – in ersten Tests kommunizierten zwei LLMs in DroidSpeak fast 2,8-mal schneller miteinander als auf Englisch. Der Trick: Statt jeden Gedankenschritt wortreich zu beschreiben, teilen sie sich nur die relevanten Daten oder Teilergebnisse mit. Das reduziert den „Redeballast“ erheblich. Noch steckt das Konzept in den Kinderschuhen (die Forscher bemerkten etwa, dass beide Agenten möglichst das gleiche Modell nutzen sollten, um Missverständnisse zu vermeiden). Doch DroidSpeak zeigt, wohin die Reise gehen könnte – KI-Agenten, die sich präzise, knapp und in maschineneigener Grammatik abstimmen, ohne Umweg über unsere Sprache.

Einen anderen kreativen Ansatz verfolgt das Experiment GibberLink, das auf einem Hackathon von ElevenLabs entstand. Hier erkannten zwei sprachbasierte KI-Assistenten (Voicebots) während einer Unterhaltung, dass ihr Gegenüber kein Mensch, sondern ebenfalls ein KI-Agent war (Gibberlink: Two AI voice assistants have a conversation | ElevenLabs). Daraufhin wechselten sie live die Sprache: weg von gesprochener Englischer Sprache, hin zu einem hyper-effizienten Sound-Protokoll. Statt Wörter zu senden, tauschten die Agenten digital kodierte Tonfolgen aus – ähnlich wie zwei Modems, nur wesentlich schneller und moderner (What is Gibberlink: The secret language between AI agents | The Jotform Blog). Das Ergebnis: Ein nahezu echtzeitfähiger Informationsaustausch, der rund 80 % effizienter war als der klassische Weg über menschliche Sprache. GibberLink nutzt hochfrequente Audio-Signale, um Daten direkt von einem Gerät zum anderen zu übertragen . Für uns Menschen klingt das wie abstraktes Zirpen, doch für die Maschinen ist es ein klares, strukturiertes „Gespräch“ in Bits und Bytes. Weil dabei weder WLAN noch Übersetzungen ins Textformat nötig sind, ist die Methode schneller, sicherer und frei von den Mehrdeutigkeiten natürlicher Sprache. Maschinen müssen sich schließlich nicht in ganzen Sätzen erklären – ihnen genügen rohe Daten und klare Signale. GibberLink zeigt auch, dass solche Alternativsprachen kein geheimnisvolles Eigenleben der KI bedeuten, sondern gezielt gestaltet wurden: Es ist ein transparentes, vordefiniertes Protokoll, um Maschinen-Interaktionen zu optimieren.

Was bedeuten diese Entwicklungen? Für die Kommunikation zwischen KI-Agenten bahnen sich strukturiere, formale Sprachen an. Ob mathematische Notationen, formale Logik oder Audio-Kodierungen – KI-Agenten der Zukunft könnten zweisprachig sein: einerseits verstehen sie uns Menschen in natürlicher Sprache, andererseits tauschen sie untereinander effizient Daten in maschineneigenen Formaten aus. Für Unternehmen könnte dies etwa heißen, dass interne Agenten-Netzwerke Informationen blitzschnell austauschen, ohne den Umweg über APIs in Textform. Vielleicht werden sogar Geschäftsregeln oder Workflows in präzise mathematische Ausdrücke übersetzt, damit ein Agent sie einem anderen ohne Interpretationsspielraum mitteilen kann. Die Herausforderung für Tech-Manager wird sein, diese neuen „Dialekte“ zu orchestrieren: Welche Standards setzen sich durch? Wie stellt man sicher, dass menschliche Entwickler noch nachvollziehen können, was die Agenten besprechen? Transparenz und Kontrolle werden hier ebenso wichtig sein wie Performance und Effizienz.

Herausforderungen und Chancen für den Mittelstand

Bevor wir uns zu sehr von den faszinierenden technologischen Möglichkeiten mitreißen lassen, ist ein realistischer Blick auf die Herausforderungen und Chancen unerlässlich – besonders für mittelständische Unternehmen. Die KI-Agenten-Revolution mag für Tech-Giganten wie Microsoft oder Google greifbar sein, doch mittelständische Firmen haben eigene Überlegungen anzustellen.

Pragmatische Implementierungsstrategien

Die Einführung von KI-Agenten ist für mittelständische Unternehmen oft komplexer als zunächst angenommen. Viele Projekte scheitern nicht an der Technologie selbst, sondern an unzureichender Vorbereitung, zu ambitionierten Erwartungen oder fehlender Begleitung durch Fachexperten. Eine erfolgreiche Implementierung erfordert klare Anwendungsfälle, die präzise auf die Geschäftsziele ausgerichtet sind und messbare Ergebnisse liefern.

Besonders herausfordernd ist dabei die richtige Priorisierung: Welche Prozesse eignen sich für den Einstieg, wo ist der Nutzen am greifbarsten, und welche organisatorischen Veränderungen sind nötig? Für Mittelständler empfiehlt sich daher ein pragmatischer, stufenweiser Ansatz mit schnell erreichbaren Zwischenzielen statt eines umfassenden Transformationsprojekts.

Integration in bestehende IT-Landschaften

Anders als Startups, die auf der grünen Wiese beginnen können, müssen mittelständische Unternehmen KI-Agenten in gewachsene IT-Landschaften integrieren. Bestehende Systeme bieten jedoch oft nicht die modernen Schnittstellen, die KI-Agenten für einen nahtlosen Zugriff benötigen. Die Realität in vielen mittelständischen Unternehmen: Eine vielfältige Landschaft aus ERP-Systemen, kundenspezifischen Entwicklungen und historisch gewachsenen Datensilos.

Hier liegt eine wichtige Chance: Statt teure Kompletterneuerungen durchzuführen, können intelligent eingesetzte KI-Agenten als „Brückentechnologie“ fungieren. Sie können bestehende Systeme miteinander verbinden und ihnen neue Funktionalitäten verleihen, ohne dass Kernsysteme sofort ersetzt werden müssen. Diese Herangehensweise ermöglicht einen evolutionären statt revolutionären Ansatz – ideal für mittelständische Unternehmen, die ihre IT-Landschaft schrittweise modernisieren möchten.

Strategische Roadmap für den Mittelstand

Basierend auf erfolgreichen Implementierungen lässt sich eine gestaffelte Roadmap für mittelständische Unternehmen ableiten:

Kurzfristig (nächste 6 Monate):

- Identifizieren Sie 2-3 konkrete Use Cases mit klarem ROI-Potenzial (z.B. automatisierte Dokumentation, Datenanalyse, erste Kunden- oder Lieferanteninteraktionen)

- Starten Sie mit einem „Single-Agent“-Ansatz: Ein KI-Agent, eine klare Aufgabe, messbare Ergebnisse

- Investieren Sie in Grundlagen-Schulungen für IT-Teams und Fachabteilungen

- Führen Sie eine Datenbestandsaufnahme durch: Welche Daten hätte ein Agent gerne? Wie zugänglich sind diese?

Mittelfristig (6-18 Monate):

- Erweitern Sie erfolgreiche Anwendungsfälle und verknüpfen Sie erste Agenten miteinander

- Implementieren Sie eine KI-Governance mit klaren Leitplanken: Wofür dürfen Agenten genutzt werden? Welche Entscheidungen treffen sie autonom?

- Schaffen Sie technische „Brücken“ zwischen modernen KI-Systemen und Legacy-Anwendungen

- Experimentieren Sie mit offenen Standards wie MCP für verbesserte Konnektivität

Langfristig (18-36 Monate):

- Etablieren Sie ein Ökosystem kooperierender Agenten für End-to-End-Prozesse

- Modernisieren Sie strategisch Ihre Dateninfrastruktur für bessere Agentenintegration

- Entwickeln Sie unternehmensspezifische, branchenrelevante Agenten statt Allzwecklösungen

- Schulen Sie Führungskräfte und Teams für die Zusammenarbeit mit KI-Agenten als „digitale Kollegen“

Die Roadmap sollte dabei für jedes Unternehmen individuell angepasst werden – je nach Branche, digitaler Reife und strategischen Zielen. Entscheidend bleibt: Beginnen Sie klein, messen Sie präzise und skalieren Sie nur erfolgreiche Ansätze. KI-Agenten sind für den Mittelstand kein Sprint, sondern ein Marathon mit vielen Etappenzielen.

Ausblick: Autonome Agenten, dezentrale Ökosysteme und neue Interfaces

Zum Schluss wagen wir einen Blick in die Glaskugel: Wohin geht die Reise der KI-Agenten in den kommenden Jahren – und was sollten Tech-Verantwortliche schon heute auf dem Schirm haben? Drei Trends stechen besonders hervor: weitere Automatisierung und agentische Autonomie, Dezentralisierung des KI-Ökosystems und innovative Schnittstellen für die Interaktion mit (und zwischen) Agenten.

Mehr Automatisierung durch agentische Autonomie

KI-Agenten werden immer fähiger, komplexe Abläufe eigenständig zu steuern. Wir sehen heute schon Ansätze wie AutoGPT oder Unternehmens-Copiloten, die nicht nur Fragen beantworten, sondern Aktionen ausführen – vom Planen einer Marketingkampagne bis zum Durchführen von Analysen. Dieser Trend zur Autonomie dürfte sich verstärken. Experten prognostizieren, dass KI-Agenten bis Ende 2025 vom bloßen Assistenzmodus in eine kollaborative Rolle wechseln werden: statt nur zuzuarbeiten, könnten sie aktiv mit anderen Agenten und Menschen an Projekten mitarbeiten. Das wirtschaftliche Potenzial wird enorm eingeschätzt – manche sprechen von bis zu 15 Billionen Dollar an Produktivitätsgewinnen, die solche agentengestützten Kollaborationen freisetzen könnten. Gleichzeitig bedeutet das für die Belegschaft einen Wandel: Millionen von Jobs werden sich wandeln und neue Fähigkeiten erfordern, um mit den digitalen Kollegen zusammenzuarbeiten. Doch bevor Angst aufkommt: Diese Agenten sollen Menschen nicht ersetzen, sondern ihnen lästige Routine abnehmen. So können sich Mitarbeiter auf Strategie, Kreativität und Fachwissen konzentrieren, während KI-Agenten im Hintergrund recherchieren, koordinieren und ausführen. Unternehmen, die diese Automation-first-Mentalität nutzen, könnten bald wesentlich effizientere Abläufe haben – zum Beispiel vollautomatisierte End-to-End-Prozesse, in denen ein Sales-Agent eingehende Leads qualifiziert, ein Finance-Agent automatisch Angebote erstellt und ein Supply-Chain-Agent Bestellungen auslöst, ohne dass ein Mensch jeden Zwischenschritt manuell anstoßen muss. Für Manager bedeutet das, Prozesse jetzt daraufhin abzuklopfen, wo „low-hanging fruits“ der Automatisierung liegen: Welche Aufgaben könnten delegiert werden? Wo braucht es Richtlinien, damit Agenten sicher agieren? Und nicht zuletzt: Wie schult man das Team, effektiv mit KI-Agenten zusammenzuarbeiten – z.B. durch das Formulieren klarer Ziele statt kleinteiliger Anweisungen.

Dezentralisierte KI-Agenten-Netzwerke

Der nächste Trend ist die Dezentralisierung. Bisher finden KI-Wunder meist in der Cloud großer Anbieter statt. Doch es zeichnen sich Modelle ab, bei denen KI-Agenten verteilt auf verschiedenen Plattformen oder sogar Geräten laufen und miteinander kooperieren. Man denke an ein Netzwerk aus spezialisierten Agenten: ein Agent sitzt lokal in der Fertigungsanlage und überwacht Maschinen, ein anderer läuft in der Cloud und optimiert Lieferketten, während ein dritter als persönlicher Assistent beim Mitarbeiter auf dem Laptop werkelt. Diese Agenten können miteinander sprechen (idealerweise über standardisierte Protokolle wie MCP) und so Wissen und Fähigkeiten dezentral teilen. Das erhöht die Robustheit – fällt ein Knoten aus, übernehmen andere – und vermeidet Abhängigkeiten von einem einzelnen monolithischen KI-System. Auch das Thema Privacy treibt Dezentralisierung: Statt alle Daten an eine zentrale KI zu senden, könnten lokale Agenten Daten vor Ort verarbeiten und nur aggregierte Ergebnisse weitergeben.

In der Tech-Branche experimentieren manche sogar mit Blockchain und Smart Contracts, um KI-Agenten truly dezentral zu orchestrieren. In solchen Szenarien agieren KI-Agenten als autonome Akteure in einem Netzwerk, die über Blockchain Transaktionen und Vertrauen absichern. Anwendungen im Web3-Bereich zeigen bereits, wie AI-Agenten etwa DeFi-Portfolios managen oder als Berater in DAO-Governance eingebunden werden (AI Agents: The Next Big Thing in Decentralized AI). Diese Verbindung von KI und Distributed Ledger könnte ermöglichen, dass Agenten wertschöpfende Aktionen 24/7 durchführen, ohne auf einen zentralen Server zu bauen – beispielsweise automatisch Handelsentscheidungen treffen und direkt on-chain ausführen. Für die meisten klassischen Unternehmen ist das noch ferne Zukunftsmusik, aber der zugrundeliegende Gedanke ist relevant: KI-Ökosysteme verteilen sich. So wie Microservices monolithische Software abgelöst haben, könnten viele kleine spezialisierte KI-Agenten, die lose gekoppelt zusammenarbeiten, einst große Einheits-KIs ablösen. Für Manager heißt das: Architekturdenken anpassen. Überlegen Sie, wie Sie mehrere KI-Dienste modular einsetzen können, anstatt auf „eine große KI-Lösung“ zu setzen. Achten Sie auf Schnittstellen und Interoperabilität, damit Sie Teile austauschen oder ergänzen können – sei es ein eigener Agent für Ihre Branche oder ein externer Service. Und behalten Sie im Auge, wie Sie Governance und Sicherheit in einem Netz von autonomen Agenten gewährleisten – hier könnten Ansätze wie Auditing-Agenten oder Policies, die in Smart Contracts gegossen sind, eine Rolle spielen.

Innovative Schnittstellen: Mensch und KI nahtlos verbinden

Der dritte Trend betrifft die Art und Weise, wie wir mit KI-Agenten interagieren – und wie diese untereinander interagieren können. Chatfenster und Tastatur sind nur der Anfang. Schon jetzt sehen wir Voice-Interfaces und Sprachassistenten, die dank fortschrittlicher Text-to-Speech und Speech-to-Text erstaunlich natürlich kommunizieren. In Zukunft werden Voice-AI-Agents allgegenwärtig: im Auto, im Konferenzraum, im Smart Home. Entwickler kombinieren Sprach-KIs mit visuellen Interfaces und AR: Man wird z.B. durch eine AR-Brille einen KI-Agenten als Hologramm sehen, der einem im Lager den Weg zum richtigen Regal weist, oder im Meeting schwebt eine visuelle Darstellung der aktuellen Datenanalyse, generiert in Echtzeit vom AI-Assistenten. Multimodale KI-Agenten können Text, Sprache, Bilder und Sensoren kombinieren, um kontextbewusster zu handeln (Multimodal AI Agents: Reimaging Human-Computer Interaction). Das eröffnet ganz neue Interfaces: Gestensteuerung (man zeigt auf ein Objekt und fragt den Agenten nach Informationen dazu), Blicksteuerung in AR-Umgebungen, oder gar Brain-Computer-Interfaces, bei denen Gedankenabsichten erkannt und vom Agenten umgesetzt werden – auch wenn Letzteres eher visionär für die 2030er klingt.