In der sich schnell entwickelnden Landschaft der KI-Automatisierung erleben wir eine Konvergenz von Technologien, die „Agentic Workflows“ leistungsfähiger und zugänglicher macht als je zuvor. Meine jüngsten Experimente mit OpenAIs neuen GPT-4.1-Modellen und n8ns Model Context Protocol (MCP)-Nodes haben spannende Möglichkeiten aufgezeigt, die Aufmerksamkeit verdienen. Lass uns diese Entwicklungen genauer betrachten und untersuchen, wie sie die Art und Weise verändern, wie wir KI-Agenten entwickeln und einsetzen.

GPT-4.1: Geschwindigkeit, Kosten und Befolgung von Anweisungen

OpenAI hat kürzlich eine Familie neuer Modelle veröffentlicht – GPT-4.1, GPT-4.1 Mini und GPT-4.1 Nano – die hauptsächlich für Entwickler gedacht sind. Trotz der etwas verwirrenden Namensgebung (ja, sie sind von 4.0 auf 4.1 gesprungen, obwohl es dazwischen ein 4o gibt), bringen diese Modelle erhebliche Verbesserungen mit sich, die sie ideal für Agentic Workflows machen.

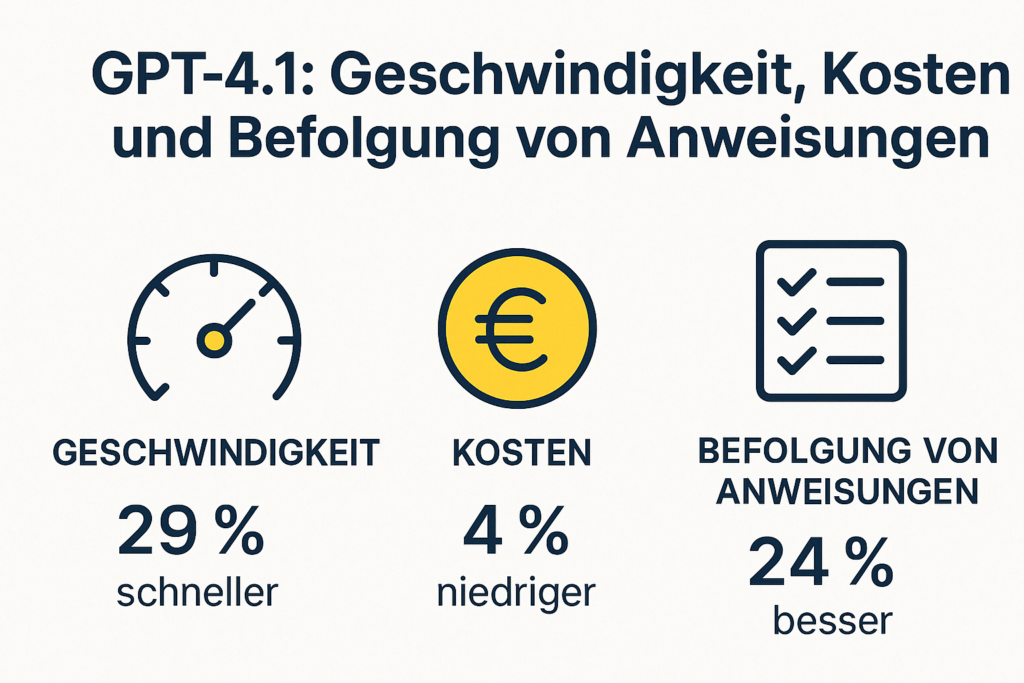

Bei meinen Tests mit n8n-basierten Agentic Workflows habe ich festgestellt, dass GPT-4.1 in mehreren Schlüsselbereichen deutlich besser abschneidet:

1. Befolgung von Anweisungen

Die bedeutendste Verbesserung, die ich beobachtet habe, ist die Präzision, mit der GPT-4.1 Anweisungen aus System-Prompts befolgt. Beim Aufbau komplexer KI-Agenten, die die richtigen Tools für bestimmte Aufgaben auswählen müssen, ist diese Präzision von unschätzbarem Wert. Das Modell wählt konsequent die passende Aktion basierend auf Benutzereingaben aus, ohne umfangreiche Anleitungen oder Hilfestellungen zu benötigen.

Dies ist besonders wichtig für Agenten, die mehrere Unter-Agenten oder Tools verwenden müssen. In einem meiner Workflows hatte ich zuvor aufwendige System-Prompts benötigt, um die korrekte Tool-Auswahl sicherzustellen. Mit GPT-4.1 können diese Prompts erheblich vereinfacht oder in einigen Fällen fast überflüssig gemacht werden.

2. Dramatisch niedrigere Latenz

Für konversationsbasierte oder sprachbasierte Agenten ist die Reaktionszeit entscheidend. GPT-4.1 reduziert die Latenz im Vergleich zu seinen Vorgängern um fast die Hälfte, wodurch Interaktionen viel natürlicher wirken. Diese Geschwindigkeitsverbesserung ist besonders in komplexen Workflows spürbar, bei denen der Agent mehrere API-Aufrufe tätigen oder erhebliche Datenmengen verarbeiten muss.

3. Kosteneffizienz

Der vielleicht praktischste Vorteil für Entwickler ist die Kostenreduzierung. GPT-4.1 Mini bietet „GPT-4o-Qualität“ zu etwa 25-fach niedrigeren Kosten. Mit Inputtoken zu 0,40 $/Million und Outputtoken zu 1,60 $/Million ist es deutlich günstiger als Claude 3.7 Sonnet (3,00 $ Input, 15,00 $ Output), während es für die meisten Aufgaben eine vergleichbare Leistung beibehält.

Diese Kosteneffizienz ist ein echter Vorteil für Produktionsumgebungen, insbesondere für Anwendungen mit hohem Volumen oder komplexe Agenten, die häufige API-Aufrufe tätigen.

MCP-Nodes in n8n: Vereinfachung der Tool-Integration

Die andere große Weiterentwicklung, die ich mir angesehen habe, ist n8ns Implementierung von Model Context Protocol (MCP)-Nodes. Diese neuen Ergänzungen der No-Code-Automatisierungsplattform machen es viel einfacher, Agentic Workflows zu erstellen und einzusetzen.

Was sind MCP-Nodes?

MCP (Model Context Protocol) ist ein Standard, der es Sprachmodellen ermöglicht, mit externen Tools und Diensten zu interagieren. n8n hat dieses Protokoll in zwei wichtigen Node-Typen implementiert:

- MCP Server Trigger: Stellt deine n8n-Workflows und -Tools für Sprachmodelle wie Claude oder GPT bereit

- MCP Client Tool: Ermöglicht deinen n8n-basierten Agenten die Kommunikation mit MCP-Servern

Anwendungen in der Praxis

Ich habe diese MCP-Nodes erfolgreich mit verschiedenen Diensten integriert, darunter:

- Google Kalender für Terminplanung

- WhatsApp für Nachrichtenautomatisierung

- Slack für Teambenachrichtigungen

- E-Mail-Systeme für Korrespondenz

- CRM-Systeme für Lead-Management

Das Schöne an diesem Ansatz ist, dass du nach Herstellung dieser Verbindungen mit all diesen Tools über natürliche Sprache in Claude oder ChatGPT (in Vorbereitung) interagieren kannst, ohne zwischen verschiedenen Anwendungen wechseln zu müssen.

Ich kann Claude jetzt zum Beispiel bitten:

- Einen Termin am nächsten Dienstag um 15 Uhr zu planen und einen Gesprächpartner dazu einzuladen

- Meinen Kalender auf Konflikte zu überprüfen

- Besprechungszeiten zu aktualisieren und Teilnehmer über Slack zu benachrichtigen

All diese Aufgaben werden ausgeführt, ohne dass ich komplexe System-Prompts schreiben oder zwischen verschiedenen Schnittstellen navigieren muss.

Aufbau deines ersten Agentic Workflows

Wenn du diese Technologie selbst erkunden möchtest, hier ein vereinfachter Ansatz zum Einstieg:

1. Einrichtung von GPT-4.1 in n8n

Beginne mit der Erstellung eines neuen Workflows in n8n und füge einen AI Agent-Node hinzu. Konfiguriere ihn zur Verwendung von GPT-4.1 Mini für das beste Gleichgewicht zwischen Kosten und Leistung. Für Konversationsagenten, die schnelle Antworten erfordern, bietet dieses Modell die ideale Balance.

2. Erstellen eines MCP-Servers

Füge einen MCP Server Trigger-Node zu deinem Workflow hinzu. Dies erstellt einen Endpunkt, der von Sprachmodellen genutzt werden kann. Verbinde dann diesen Trigger mit verschiedenen Tool-Nodes basierend auf deinen Anforderungen:

- Google Kalender-Nodes für Terminplanung

- E-Mail-Nodes für Kommunikation

- Slack-Nodes für Benachrichtigungen

- Datenbank-Nodes für Datenabruf und -speicherung

3. Definition von Tool-Beschreibungen

Für jedes Tool, das mit deinem MCP-Server verbunden ist, stelle detaillierte Beschreibungen bereit, was das Tool tut und welche Parameter es benötigt. Zum Beispiel:

Kalenderereignis erstellen:

Beschreibung: Erstellt ein neues Ereignis im primären Google-Kalender.

Erforderliche Parameter: start_time, end_time

Optionale Parameter: attendees, summary

Diese Beschreibungen helfen dem Sprachmodell zu verstehen, wann und wie es jedes Tool verwenden soll.

4. Verbindung mit Claude oder ChatGPT

Der letzte Schritt ist die Verbindung deines MCP-Servers mit einer Sprachmodell-Schnittstelle wie Claude oder ChatGPT. Dies geschieht typischerweise durch Kopieren der Produktions-URL aus deinem MCP Server-Node und Hinzufügen zur Konfiguration deiner gewählten KI-Schnittstelle.

Die Zukunft der Arbeitsautomatisierung

Was diese Kombination von Technologien so spannend macht, ist, dass sie einen fundamentalen Wandel in unserer Interaktion mit Software darstellt. Statt zwischen mehreren Schnittstellen zu navigieren und verschiedene Systeme zu erlernen, können wir einfach in natürlicher Sprache beschreiben, was wir erreichen möchten.

Dieser Ansatz ist besonders wertvoll für:

- Aufgabenautomatisierung: Bewältigung sich wiederholender Aufgaben über mehrere Plattformen hinweg

- Content-Creation-Workflows: Nutzung von KI zur Generierung, Verfeinerung und Verteilung von Inhalten

- Kundenservice: Aufbau von Agenten, die auf mehrere Systeme zugreifen können, um Kundenprobleme zu lösen

- Persönliche Produktivität: Erstellung von Assistenten, die deinen Kalender, Kommunikation und Informationsbedürfnisse verwalten

Herausforderungen und Überlegungen

Obwohl diese Fortschritte vielversprechend sind, sind sie nicht ohne Herausforderungen:

- Authentifizierung und Sicherheit: Die Verwaltung des Zugriffs auf sensible Systeme erfordert sorgfältige Überlegungen

- Zuverlässigkeit: Sicherstellen, dass das Sprachmodell Befehle korrekt interpretiert und die richtigen Tools verwendet

- Kostenmanagement: Überwachung der API-Nutzung zur Vermeidung unerwarteter Ausgaben

- Wartung: Aktualisierung der Verbindungen bei API-Änderungen

Fazit

Die Kombination aus OpenAIs GPT-4.1-Modellen und n8ns MCP-Implementierung stellt einen bedeutenden Schritt in Richtung Demokratisierung von KI-Agenten dar. Wir bewegen uns auf eine Zukunft zu, in der komplexe Workflows durch natürliche Sprache ausgelöst und verwaltet werden können, wodurch Technologie zugänglicher und intuitiver wird.

Für Entwickler und Automatisierungsenthusiasten ist jetzt der perfekte Zeitpunkt, um mit diesen Tools zu experimentieren. Die Kostenhürden wurden erheblich gesenkt, und die technische Komplexität ist besser handhabbar als je zuvor.

Ob du persönliche Produktivitätstools oder unternehmenstaugliche Automatisierungssysteme aufbaust – der Agentic-Workflow-Ansatz bietet spannende neue Möglichkeiten, die es zu erkunden gilt.

Lass uns zusammenarbeiten!

Möchtest du mehr über GPT-4.1, MCP oder Agentic Workflows erfahren? Oder planst du, diese Technologien in deinem Unternehmen einzusetzen und suchst professionelle Unterstützung? Ich biete individuelle Beratung und Implementierungshilfe für Unternehmen und Teams, die ihre Prozesse mit diesen fortschrittlichen Technologien automatisieren möchten.

Kontaktiere mich für ein unverbindliches Erstgespräch, in dem wir über deine spezifischen Anforderungen und Ziele sprechen können. Gemeinsam können wir maßgeschneiderte Lösungen entwickeln, die deine Arbeitsabläufe effizienter gestalten und dein Team von repetitiven Aufgaben entlasten.